La innovación y el desarrollo de nuevas soluciones en el mercado de semiconductores no cesa ni un instante. TSMC acaba de anunciar un importante salto en cuanto a la fabricación CoWoS que se plasmara a partir de 2023. Esta nueva solución permite apilar un número mayor de capas de memoria con respecto a la tecnología actual. Para el futuro podríamos ver GPU para IA con hasta 192GB HBM2.

Chip-on-Wafer-on-Substrate (CoWoS) es la tecnología de apilación de diferentes circuitos integrados en un solo chip. Vendría a ser una tecnología similar a Intel Foveros, que permite desarrollar chips múltiples. En resumidas cuentas, en un mismo DIE podríamos tener diferentes circuitos, mejorando la densidad y reduciendo los costes de fabricación.

| Vista previa | Producto | Precio | |

|---|---|---|---|

|

Kingston A400 SSD 480GB |

34,90 EUR |

Comprar en Amazon |

TSMC planea dar un gran salto en CoWoS en tres años

Actualmente la tecnología CoWoS tenía un límite de apilamiento de 6 stacks de memoria HBM2. Esto hace que se puedan desarrollar GPU para IA y similares de hasta 96GB HBM2 en un mismo encapsulado. Mediante estas mejoras en los procesos de fabricación y la implementación de nuevas tecnologías se podría llegar a los 192GB HMB2, que es el doble.

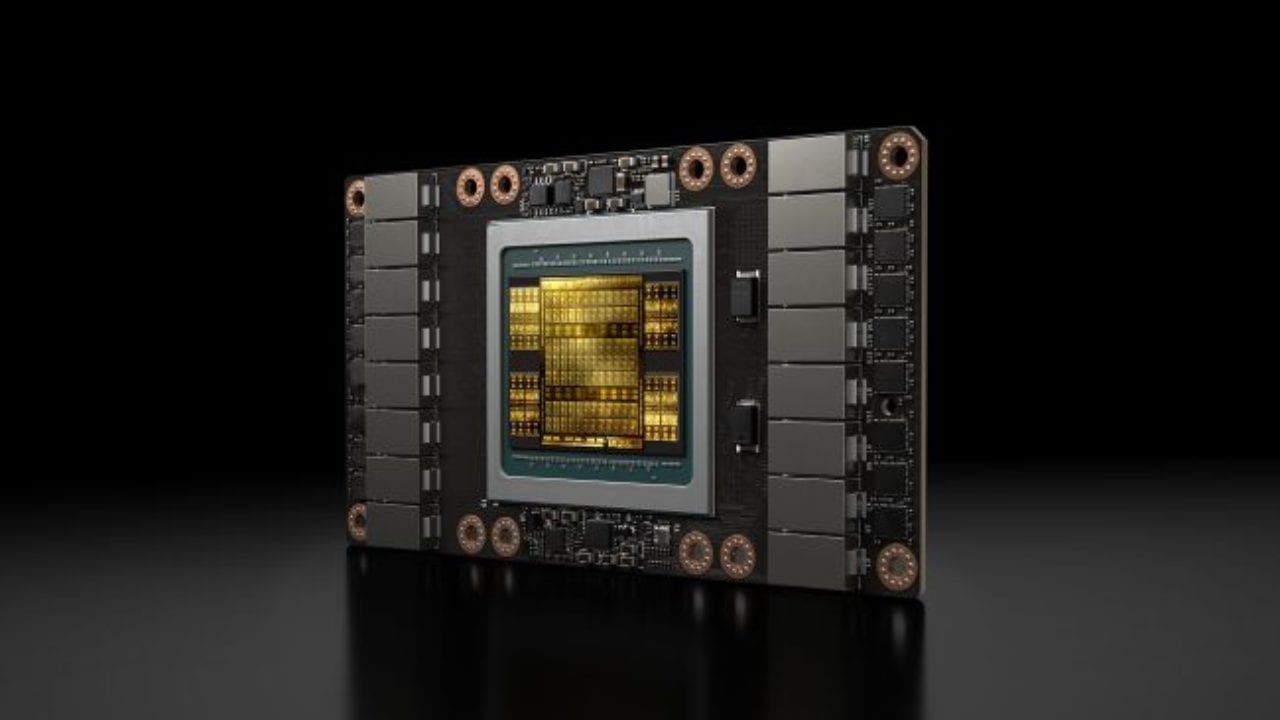

NVIDIA actualmente está usando esta tecnología en las gráficas profesionales V100 de arquitectura Volta. AMD también usa esta tecnología, pero en su caso en los chips Radeon VII que integran chips HBM2 en el mismo encapsulado. Pese a que AMD la ha usado en su división de gráficos gaming, está pensado para gráficas del sector profesional. Destacar que AMD ya no utilizara más memorias HBM2 en sus gráficas gaming debido la nueva arquitectura RDNA.

Esta mejora de diseño CoWoS podría ofrecer un nuevo salto en las soluciones para la Inteligencia Artificial, Machine Learning, etc. Aunque hay que tener en cuenta que apilar tantas memorias HBM2 es muy complicado y podría suponer un gran encarecimiento del producto final. La NVIDIA V100 usa 32GB HBM2 de los 96GB HBM2 posibles mediante la tecnología CoWoS de TSMC.

[irp]Fuente: TPU