Índice de contenido

Desarrollan una simulación de 40 GPU del tamaño de una oblea que lo hace 19 veces más potente y hasta 140 veces más eficiente que un sistema de servidores de GPU del mismo número de GPU.

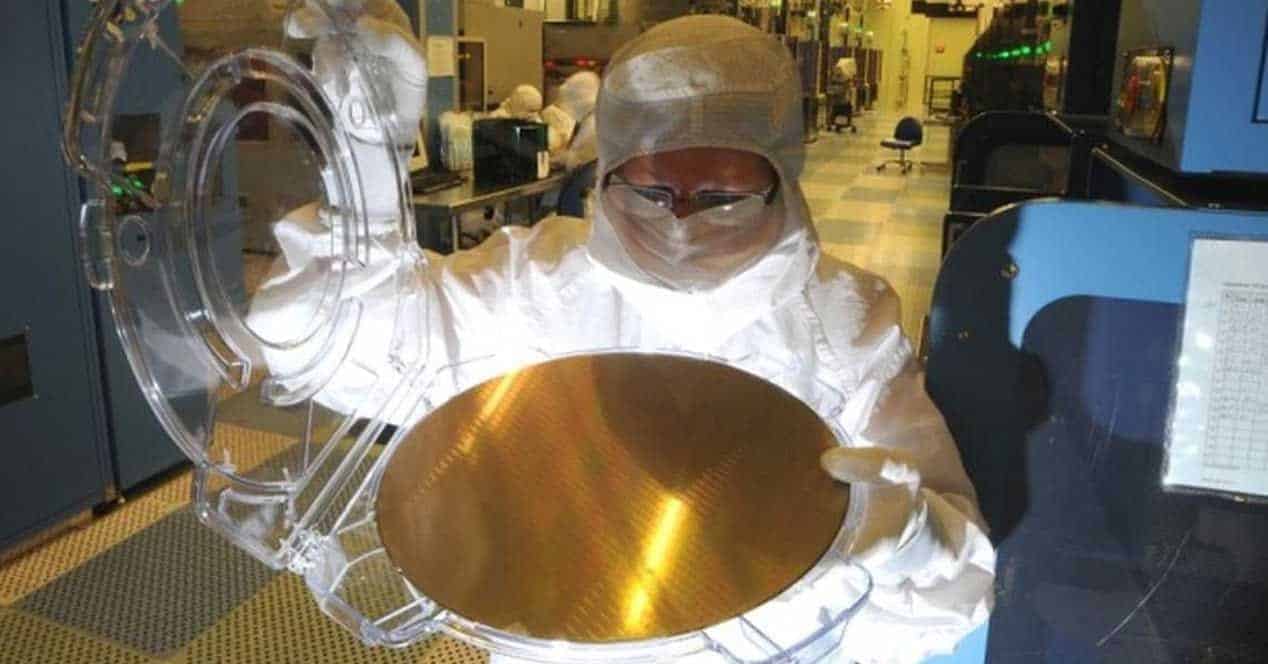

Las tarjetas gráficas actuales se basan en una GPU y memorias. Es una configuración ‘sencilla’ montada en una PCB con una refrigeración dedicada. Pueden mover juegos, realizar cálculos complejos o codificación de archivos. Este sistema podría evolucionar gracias a una investigación de Rakesh Kumar y su grupo de investigadores. Durante el Simposio Internacional IEEE sobre Arquitectura de Computadores de Alto rendimiento, han presentado el prototipo de un ordenador de escala de obleas que contaría con 40 GPU.

Algo de historia sobre esta idea

Gene Amdahl, uno de los pioneros de la computación, pensó en la década de 1980 un modo de acelerar la computación. Para ello pensó en procesadores del tamaño de una oblea de silicio. Tener tanta potencia de computación nos permite que la gran mayoría de los datos estén en los procesadores. Esto evita que tengan que ser movidos en un circuito integrado hacia la memoria u otros chips. Lo más interesante de esto es que la computación se aceleraría de manera significativa y el consumo de energía se reduciría de manera significativa.

Para desarrollar esta idea Amdahl consiguió mediante capitalistas de riesgo, un total de 230 millones de dólares, cosa que permitió fundar Trilogy Systems, con la finalidad de hacerlo realidad. Aquel primer intento de “integración a escala de obleas” fue un rotundo desastre.

Los ingenieros de las Universidad de Illinois y la Universidad de California han considerado que ahora es el momento de dar una nueva oportunidad a esta práctica.

Retomando la idea de Amdahl

Ahora Rakesh Kumar y su equipo de investigadores han pensado en un escalado de obleas de hasta 40 GPU. Este sistema no ha sido desarrollado de manera física, solo se ha montado en simuladores. Dichas simulaciones permite acelerar los cálculos en 19 veces, además se ha podido reducir el consumo energético y la demora de la señal en nada menos que 140 veces.

“El gran problema que estamos tratando de resolver es la sobrecarga de comunicación entre las unidades computaciones”, según explica Kumar.

Los grandes superordenadores distribuyen de manera común la carga de las aplicaciones entre cientos de GPU que se distribuyen en placas de circuito impreso las cuales están separadas y se comunican mediante diferentes enlaces a larga distancia. Dichos enlaces tienen la propiedad de generar pérdidas de energía y generar cuellos de botella. No solamente eso, debido a las propiedades mecánicas de los chips y las propias placas de circuitos impresos, los procesadores deben mantener los paquetes limitados de manera significativa tanto en entradas como en salidas. Esto implica que la comunicación entre dos GPU genera “una cantidad increíble de gastos generales”, explica Kumar.

Se necesita en la actualidad la interconexión entre GPU que ofrezca una gran rapidez en la comunicación, sea eficiente energéticamente y tan interconexiones como sea posible. Han calculado que los sistemas más potentes podrían tener 40 GPU integradas que actuarían como una GPU gigante. El programador básicamente lo ve todo “como la misma GPU”, según ha explicado Kumar.

Existen restricciones técnicas

Kumar y su equipo de investigadores han tenido que añadir una serie de restricciones especiales a la hora de diseñar la GPU a una escala de obleas. Una de las más importantes es la cantidad de calor que se tenía que disipar en cada oblea, el sistema de comunicación entre GPU más eficiente y el modo de suministrar energía a toda la red de obleas.

El problema más grande de la comunicación actual de GPU es que teniendo en cuenta que cada GPU consumo 1 voltio, el cableado para una cantidad de 40 GPU, consume 2 kilovatios completos. El sistema desarrollado por el equipo de Kumar es de 48 voltios, lo cual vuelve al sistema más eficiente, reduciendo la potencia perdida. Dicha solución requiere de reguladores de tensiones y condensadores adicionales de acondicionamiento de la señal alrededor de la oblea, ocupando el espacio que podría haber ido destinado a más módulos GPU.

Pese a todo solo han podido comprimir 41 GPU. Mediante simulaciones de diseño, han encontrado que aceleraría la computación de datos y que consumiría mucho menos que un sistema de GPU mediante servidores.

Fuente: ieee.org